Spark 监控

借助 Spark 插件,您可以在 IDE 中直接监控您的 Spark 集群和已提交的作业。

本章内容:

连接到 Spark 服务器

在 Big Data Tools 窗口中,点击

并选择 Spark。

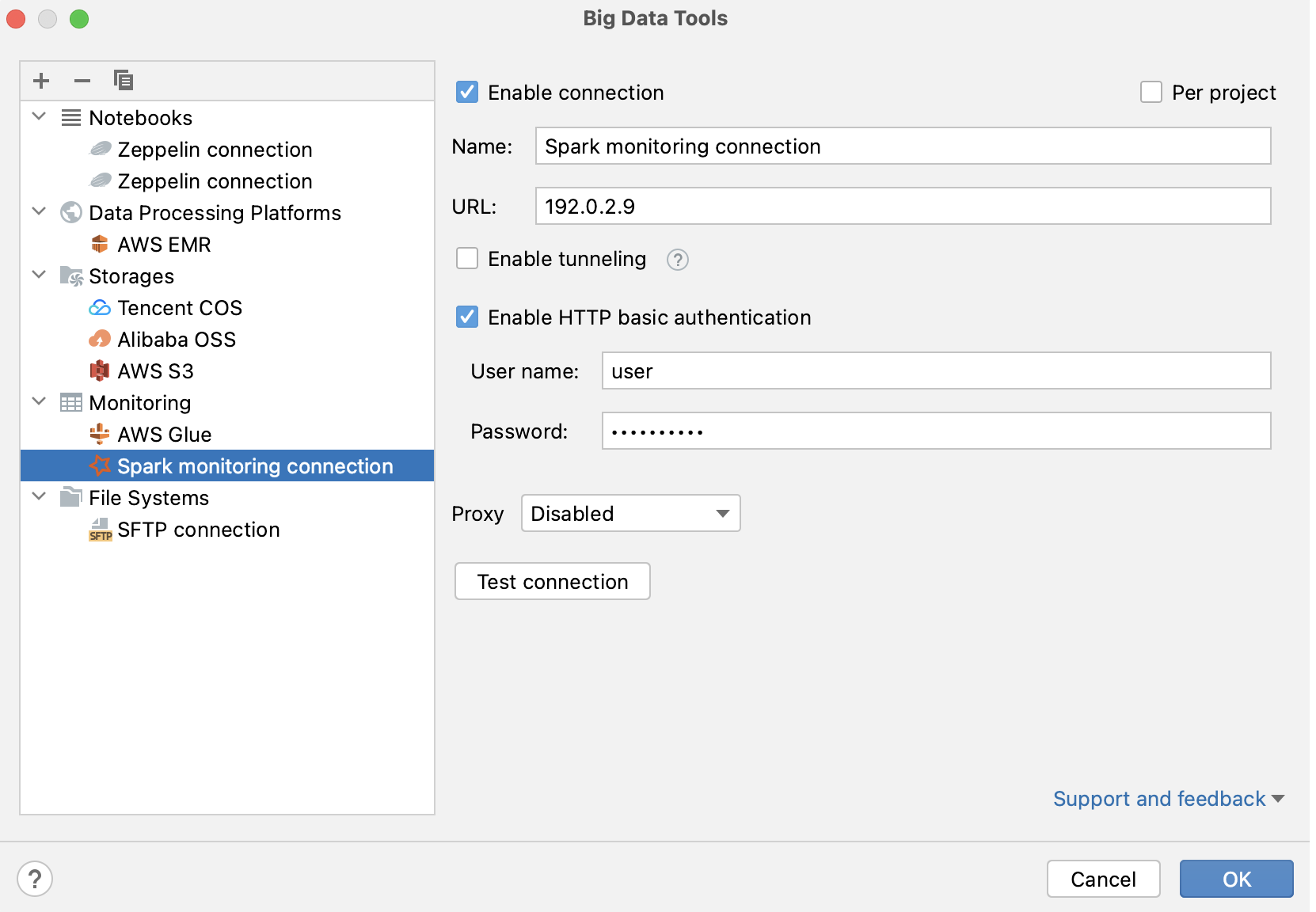

在打开的 Big Data Tools 对话框中,指定连接参数:

名称 :连接名称,用于与其他连接区分。

URL: Spark History 服务器的 URL(通常运行在端口 18080)。

可选,您可以设置:

按项目 :选择后仅为当前项目启用这些连接设置。 如果希望在其他项目中也可见此连接,请清除此复选框。

启用连接 :如果要禁用此连接,请清除此复选框。 默认情况下,新建的连接处于启用状态。

启用隧道 :创建到远程主机的 SSH 隧道。 如果目标服务器位于专用网络中,但可以通过 SSH 连接到该网络中的某个主机,则此功能会很有用。

选中复选框并指定 SSH 连接配置(点击 ... 以创建新的 SSH 配置)。

启用 HTTP 基本身份验证 :使用指定的用户名和密码通过 HTTP 进行身份验证的连接。

代理 :选择是否使用 IDE 代理设置 ,或指定自定义代理设置。

填写设置后,点击 测试连接 以确保所有配置参数均正确。 然后点击 确定。

通过正在运行的作业从 Zeppelin 建立连接

如果安装了 Zeppelin 插件,您可以通过在 Zeppelin 笔记本中打开 Spark 作业来快速连接到 Spark 服务器。

在包含 Spark 的 Zeppelin 笔记本中,运行一个段落。

点击 打开作业 链接。 在打开的通知中,点击 链接。

如果您已经拥有到作业正在运行的 Spark History 服务器的连接,请点击 选择连接 并从列表中选择它。

在打开的 Big Data Tools 对话框中,验证连接设置并点击 测试连接。 如果连接已成功建立,请点击 确定 完成配置。

建立到 Spark 服务器的连接后,将显示 Spark 监控 工具窗口。

您可以随时通过以下方式之一打开连接设置:

转到 工具 | Big Data Tools 设置 设置页面  Ctrl+Alt+S。

打开 Big Data Tools 工具窗口( ),选择一个 Spark 连接,然后点击

。

在 Spark 监控 工具窗口的任意选项卡中,点击

。

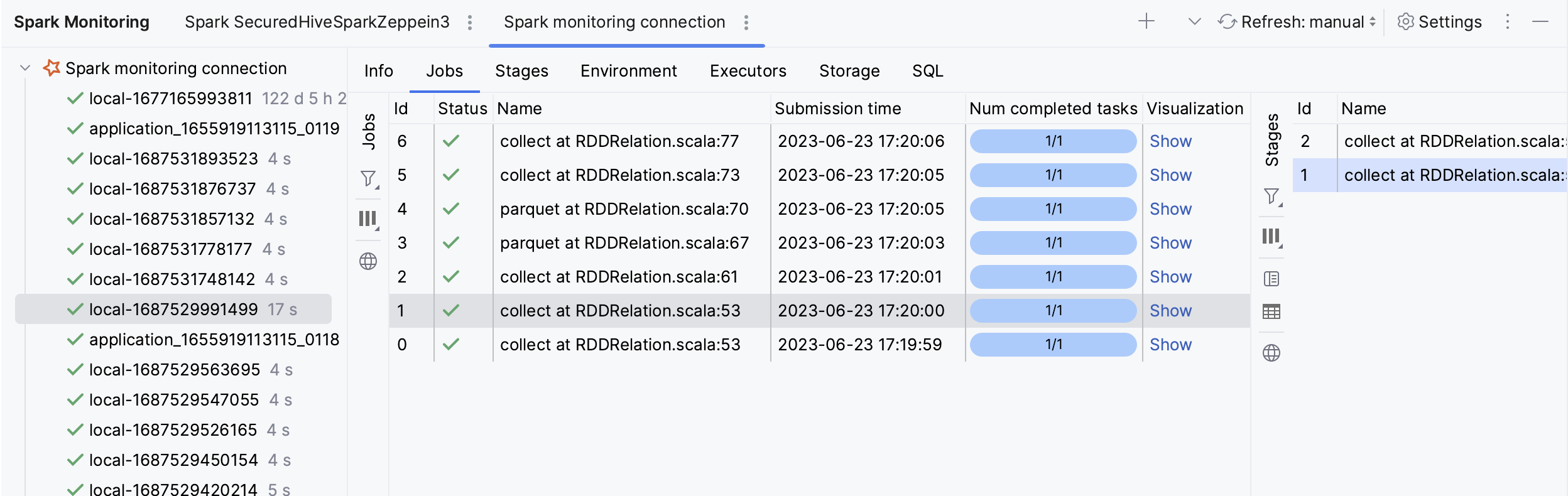

在 Spark 监控 工具窗口中选择一个应用时,您可以使用以下选项卡来监控数据:

信息 :关于已提交应用的高层信息,例如 App ID 或 Attempt ID。

作业 :应用作业的摘要。 点击某个作业以查看其详细信息。 使用 可视化 选项卡来 查看作业 DAG。

阶段 :每个阶段的详细信息。

环境 :环境与配置变量的值。

执行器 :为应用启动的进程,用于运行任务,并在任务之间将数据保存在内存或磁盘存储中。 使用 日志 选项卡查看执行器 stdout 和 stderr 日志。

存储 :持久化的 RDD 和 DataFrame。

SQL :有关 SQL 查询执行的详细信息(如果该应用使用了 SQL)。

您还可以预览关于 任务 的信息,它们是发送到某个执行器的工作单元。

有关数据类型的更多信息,请参阅 Spark 文档。

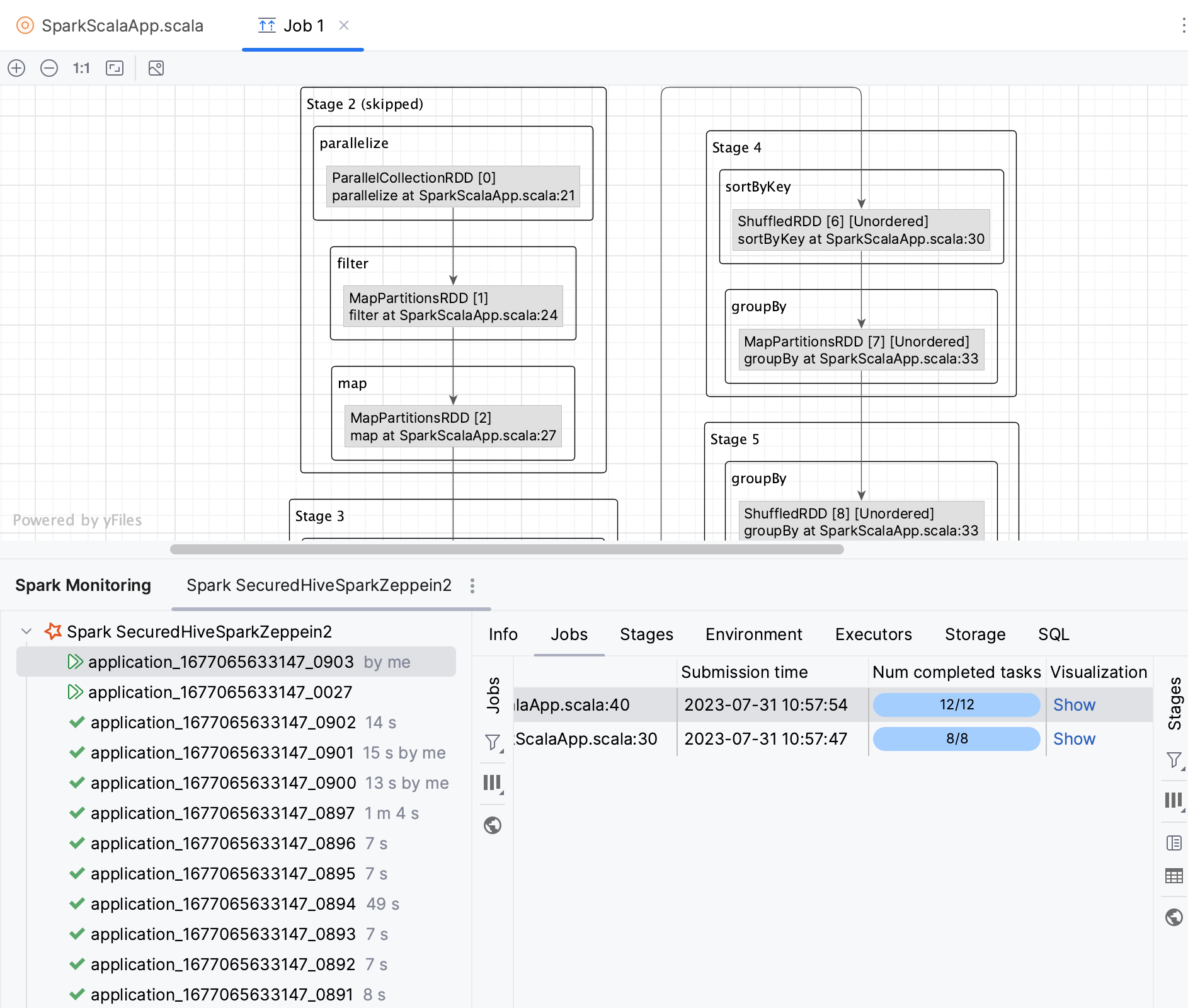

从 DAG 图导航到源代码

DAG(有向无环图)表示 Spark 作业的逻辑执行计划。 与 Spark UI 中一样,您可以可视化 Spark 作业的 DAG。 借助 PyCharm,您还可以从 DAG 快速导航到源文件中的相应代码片段。

打开 Spark 监控 工具窗口: 。

选择一个应用,并打开 作业 选项卡。

在 可视化 列中,点击 显示。

这将在新的编辑器选项卡中打开作业可视化。

在图中,双击任意操作。

您将被重定向到您的源代码文件中的相应操作。

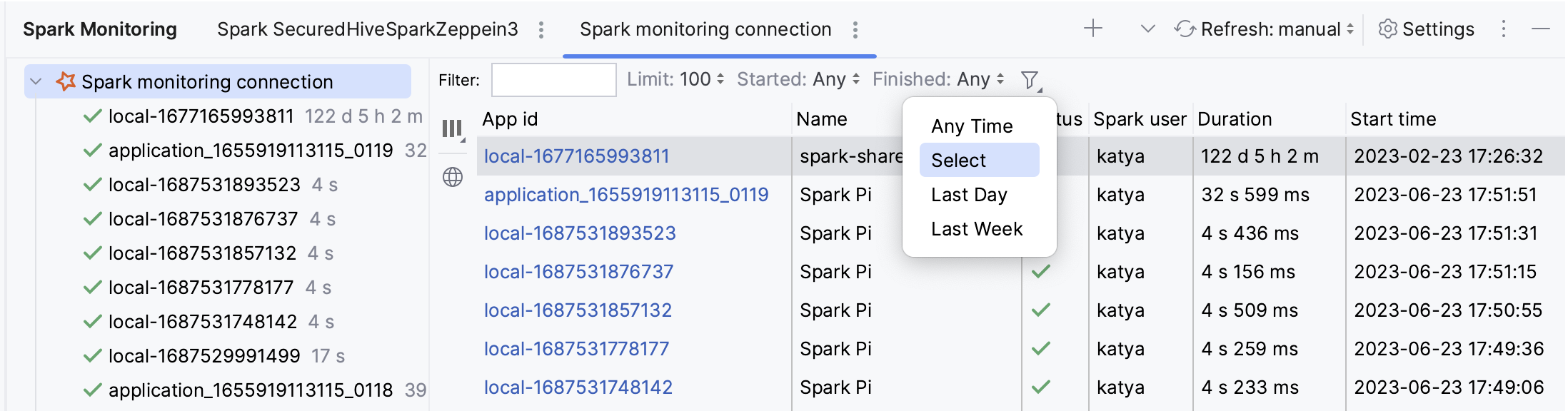

过滤监控数据

在 Spark 监控 工具窗口中,使用以下过滤器来过滤应用:

筛选器 :输入应用名称或 ID。

限制 :更改显示的应用数量上限,或选择 全部 以显示全部。

已开始 :按开始时间过滤应用,或选择 任意。

已完成 :按完成时间过滤应用,或选择 任意。

:仅显示正在运行或已完成的应用。

在 作业、 阶段 和 SQL 选项卡中,您还可以使用

按状态过滤数据。

您可以随时在 Spark 监控 工具窗口中点击 ,手动刷新监控数据。 或者,您可以使用位于 刷新 按钮旁边的列表,配置按一定时间间隔自动更新。