使用本地模型

默认情况下,AI Assistant 提供对用于 AI 相关功能的 预定义云模型集合的访问。 不过,您可以将其配置为使用由第三方提供的自定义本地模型。

支持以下第三方提供商:

Ollama – 用于本地运行和管理语言模型的命令行工具和运行时环境。 在 Ollama 模型库中浏览可用模型。

LM Studio – 一款简化本地运行和操作开源 LLM 的桌面应用程序。 在 LM Studio 模型目录中浏览可用模型。

其他 OpenAI-compatible 接口,例如:

llama.cpp – 一个用于本地运行大型语言模型的 C++ 框架。 在 Hugging Face 模型目录中浏览可用模型。

LiteLLM – 一款轻量工具,可通过单一 OpenAI-compatible API 连接多个不同的 AI 模型。

连接到第三方提供商

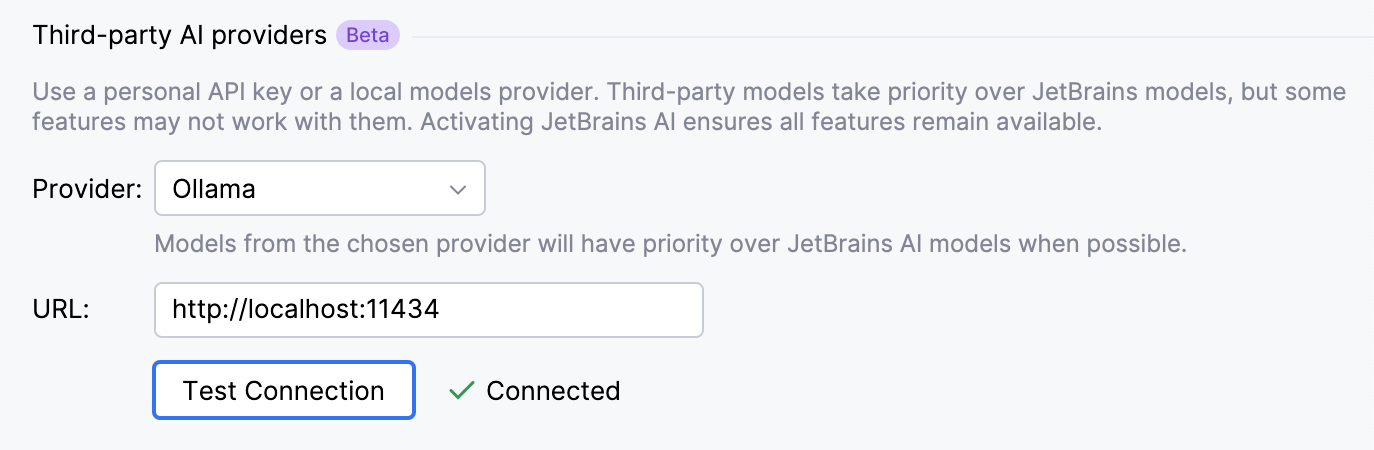

如果您想使用第三方提供商的模型,首先需要连接到该提供商。 为此,您需要启用相应的提供商并指定其可访问的 URL。

转到 。

在 第三方 AI 提供商 部分,选择您的 LLM 提供商并指定其可访问的 URL。 点击 测试连接 以检查是否成功建立连接。

点击 Apply 以保存更改。

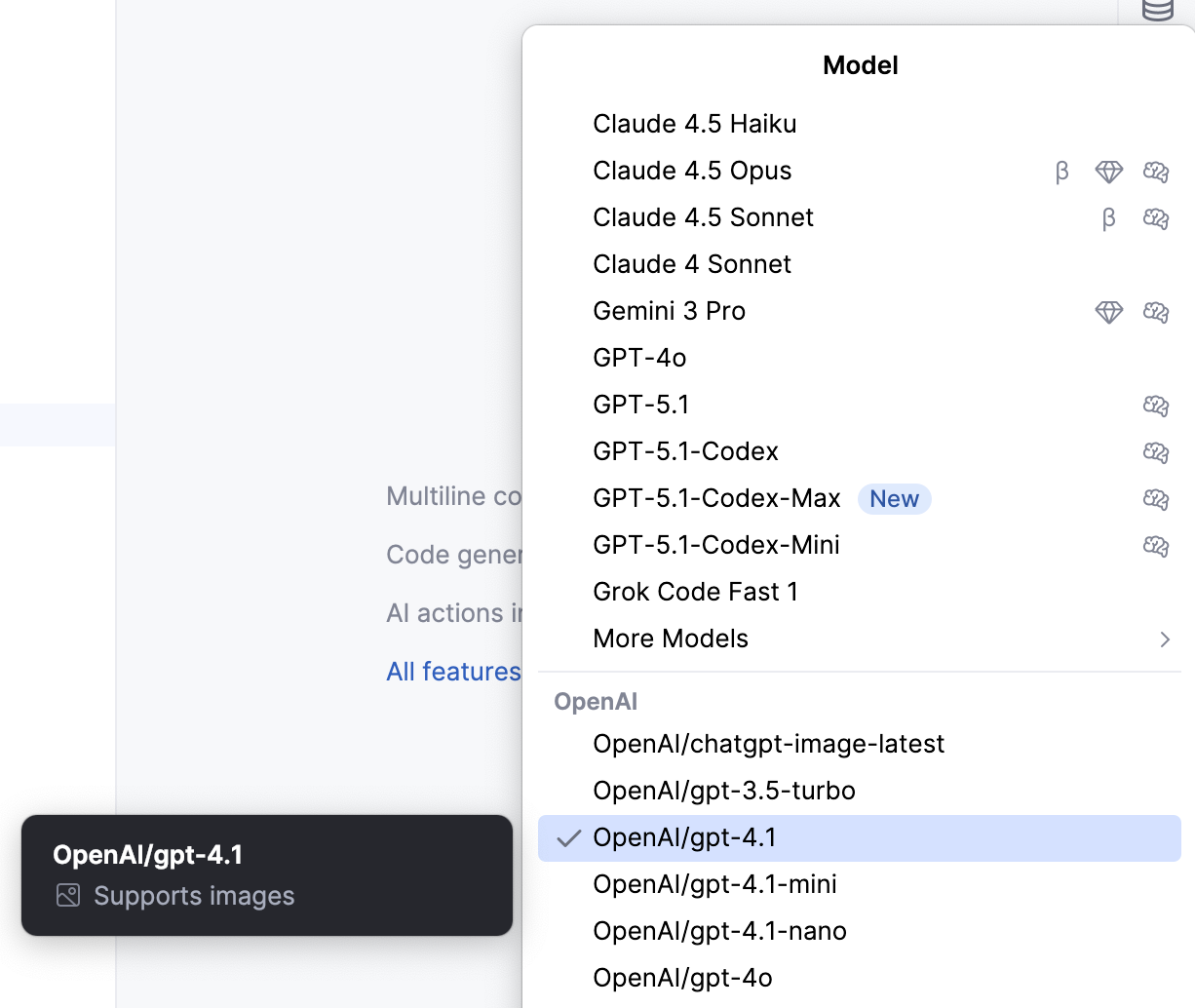

连接建立后,配置的模型将可供使用。 您可以 选择这些模型以在聊天中处理请求。

在 AI 助理功能中使用自定义模型

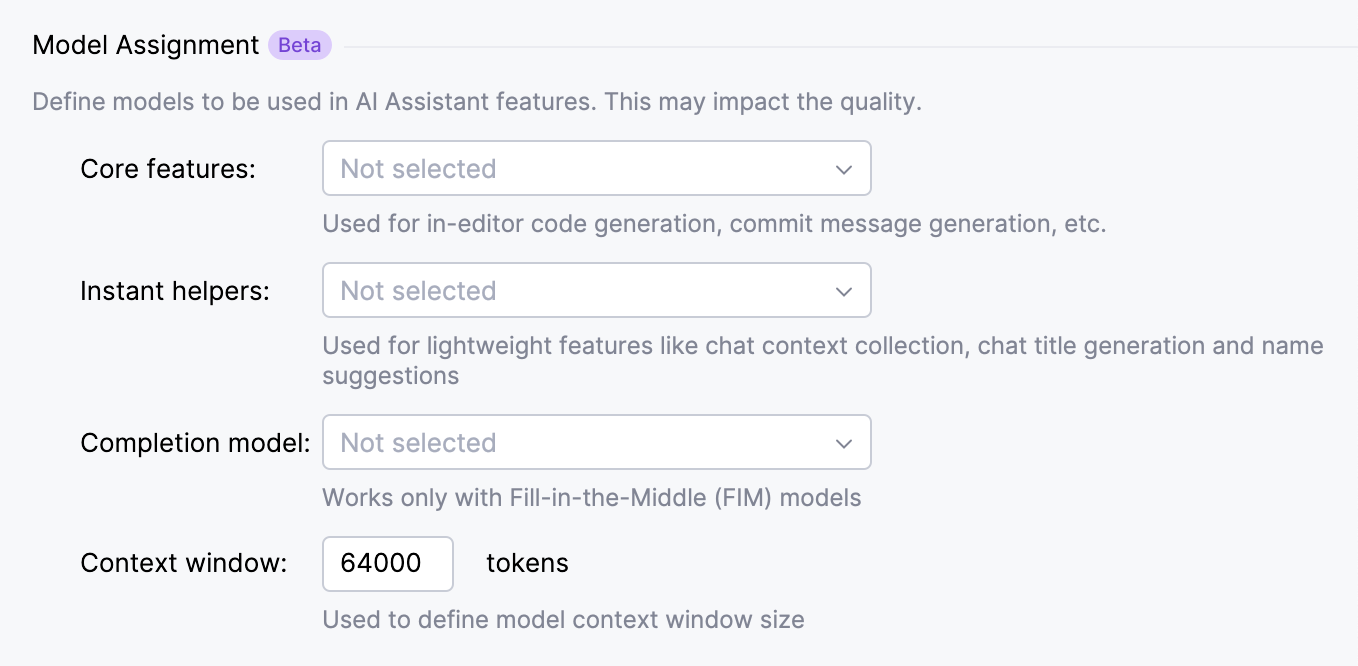

自定义模型也可用于其他 AI Assistant 功能,例如代码补全、编辑器内代码生成、提交信息生成等。

配置用于 AI 功能的自定义模型:

配置模型上下文窗口

AI Assistant 允许您为本地模型配置 模型上下文窗口。 较大的窗口可让模型在请求中处理更多上下文,而较小窗口可减少内存使用并可能提升性能。 这有助于在上下文长度与系统资源之间实现平衡。

配置模型上下文窗口:

转到 。

配置您的第三方提供商,以便本地模型可供使用。

在 本地模型 部分,根据需要调整 上下文窗口 设置。 默认值为 64 000 个 token。

点击 Apply 以保存更改。

切换为离线模式

如果您希望仅使用本地模型并限制对远程模型的调用,可以启用离线模式。 在此模式下,大部分云模型调用将被阻止,所有 AI 相关功能将依赖本地模型。

启用离线模式:

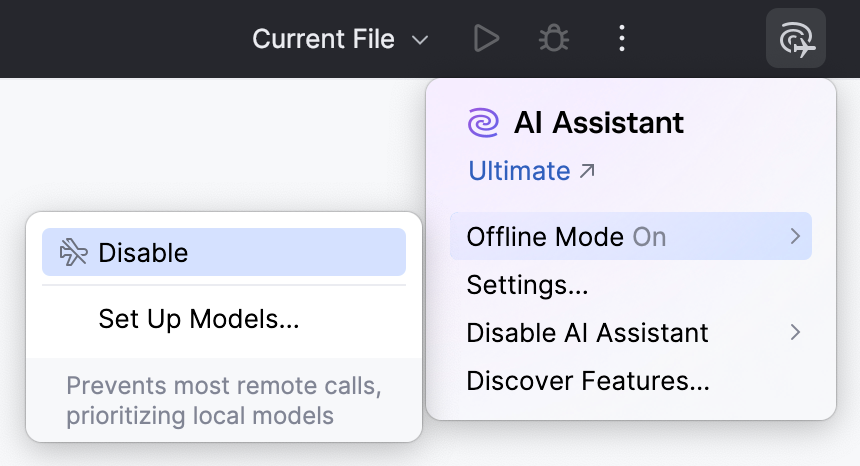

完成相关设置后,您可以在需要时切换开启或关闭离线模式:

点击窗口标题栏中工具栏的

JetBrains AI 微件。

将鼠标悬停在 离线模式 选项上,并点击 Enable 或 禁用。